O que é o Apache Spark e como ele funciona?

Em comparação com seus antecessores, como o Hadoop, ou concorrentes, como o PySpark, o Apache Spark se destaca graças ao seu desempenho impressionantemente rápido. Esse é um dos aspectos mais importantes ao consultar, processar e analisar grandes quantidades de dados. Como uma estrutura de análise de big data e na memória, o Spark oferece muitos benefícios para análise de dados, aprendizado de máquina, streaming de dados e SQL.

O que é o Apache Spark?

O Apache Spark, a estrutura de análise de dados de Berkeley, é uma das plataformas de big data mais populares do mundo e é um “projeto de nível superior” da Apache Software Foundation. O mecanismo de análise é usado para processar grandes quantidades de dados e analisá-los ao mesmo tempo em clusters de computadores distribuídos. O Spark foi desenvolvido para atender às demandas de big data com relação a velocidades de computação, capacidade de expansão e escalabilidade.

Ele tem módulos integrados que são benéficos para cloud computing, aprendizado de máquina, aplicativos de IA, bem como dados gráficos e de streaming. Devido à sua potência e escalabilidade, o mecanismo é usado por grandes empresas, como Netflix, Yahoo e eBay.

O que torna o Apache Spark especial?

O Apache Spark é um mecanismo muito mais rápido e avançado do que Apache Hadoop ou Apache Hive. Ele processa tarefas 100 vezes mais rápido em comparação com o Hadoop se o processamento for realizado na memória e dez vezes mais rápido se estiver usando o disco rígido. Isso significa que o Spark oferece às empresas um desempenho aprimorado que, ao mesmo tempo, reduz os custos.

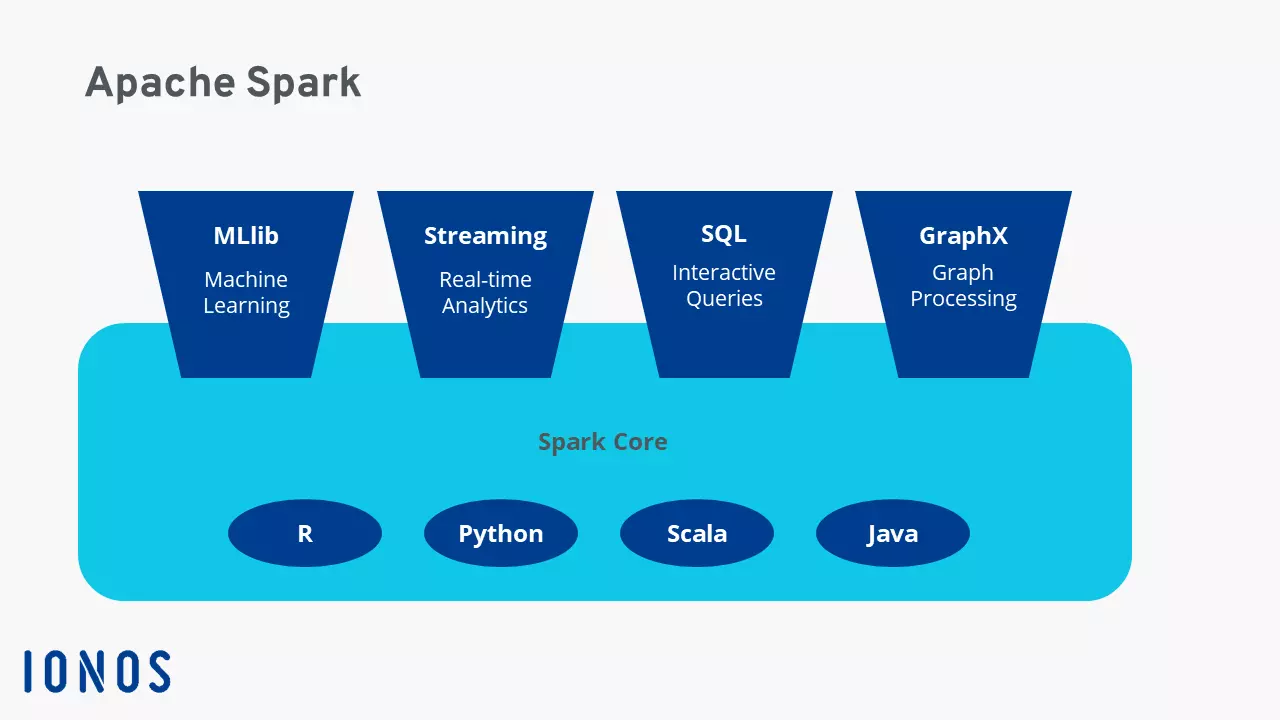

Um dos aspectos mais interessantes do Spark é sua flexibilidade. O mecanismo pode ser executado não apenas como uma opção autônoma, mas também em clusters do Hadoop executados pelo YARN. Ele também permite que os desenvolvedores escrevam aplicativos para o Spark em diferentes linguagens de programação. Não é apenas SQL que pode ser usada, mas também Python, Scala, R ou Java.

Há outras características que tornam o Spark especial, por exemplo, ele não precisa usar o sistema de arquivos Hadoop e também pode ser executado em outras plataformas de dados, como AWS S3, Apache Cassandra ou HBase. Além disso, ao especificar a fonte de dados, ele processa tanto processos em lote, como é o caso do Hadoop, quanto dados de fluxo e diferentes cargas de trabalho com código quase idêntico. Com um processo de consulta interativo, você pode distribuir e processar dados atuais e históricos em tempo real, bem como executar análises de várias camadas no disco rígido e na memória.

Como o Spark funciona?

A maneira como o Spark funciona baseia-se no modelo hierárquico primário-secundário, anteriormente conhecido como modelo mestre-escravo. Para isso, o driver do Spark funciona como um nó mestre gerenciado pelo gerenciador de cluster. Este, por sua vez, gerencia os nós escravos e encaminha a análise de dados para o cliente. A distribuição e o monitoramento das execuções e consultas são realizados pelo SparkContext, criado pelo driver do Spark. Ele coopera com os gerentes de cluster sobre como eles oferecem o Spark, o Yarn, o Hadoo ou o Kubernetes. Isso, por sua vez, cria conjuntos de dados distribuídos resilientes (RDDs).

O Spark define quais recursos são usados para consultar ou salvar dados ou para onde os dados consultados devem ser enviados. Ao processar dinamicamente os dados do mecanismo diretamente na memória dos clusters de servidores, ele reduz a latência e oferece um desempenho muito rápido. Além disso, os fluxos de trabalho paralelos são usados em conjunto com o uso de memória virtual e física.

O Apache Spark também processa dados de diferentes armazenamentos de dados. Entre eles, você encontrará o Hadoop Distributed File System (HDFS) e armazenamentos de dados relacionais, como o Hive ou bancos de dados NoSQL. Além disso, há o processamento na memória ou no disco rígido, que aumenta o desempenho. Qual deles depende do tamanho dos conjuntos de dados correspondentes.

RDDs como um conjunto de dados distribuído e à prova de erros

Conjuntos de dados distribuídos e resilientes são importantes no Apache Spark para processar dados estruturados ou não estruturados. Eles são agregações de dados tolerantes a erros, que o Spark distribui usando clustering em clusters de servidores e os processa ao mesmo tempo ou os move para o armazenamento de dados. Também é possível encaminhá-los para outros modelos de análise. Nos RDDs, os conjuntos de dados são separados em partições lógicas que são abertas, recém-criadas ou processadas, bem como calculadas com transformações e ações.

Com a Hospedagem Linux da IONOS, você pode usar seus bancos de dados conforme necessário. Ela é flexivelmente escalável, tem proteção SSL e DDoS, bem como servidores seguros.

DataFrames e conjuntos de dados

Outros tipos de dados processados pelo Spark são conhecidos como DataFrames e Datasets. Os DataFrames são APIs configuradas como tabelas de dados em linhas e colunas. Por outro lado, os conjuntos de dados são uma extensão dos DataFrames para uma interface de usuário orientada a objetos para programação. De longe, os DataFrames desempenham um papel fundamental, especialmente quando usados com a Machine Learning Library (MLlib) como uma API com uma estrutura exclusiva em todas as linguagens de programação.

Qual linguagem o Spark usa?

O Spark foi desenvolvido usando Scala, que também é a linguagem principal do mecanismo Spark Core. Além disso, o Spark também tem conectores para Java e Python. O Python oferece muitos benefícios para uma análise de dados eficaz, especialmente para a ciência e a engenharia de dados com o Spark, em conexão com outras linguagens de programação. O Spark também oferece suporte a interfaces de alto nível para a linguagem de ciência de dados R, que é usada para grandes conjuntos de dados e aprendizado de máquina.

Quando o Spark é usado?

O Spark é adequado para muitos setores diferentes graças à sua biblioteca variada e ao armazenamento de dados, às muitas linguagens de programação compatíveis com APIs e ao processamento eficaz na memória. Se você precisar processar, consultar ou calcular grandes e complicadas quantidades de dados, graças à sua velocidade, escalabilidade e flexibilidade, o Spark é uma ótima solução para as empresas, especialmente quando se trata de big data. O Spark é particularmente popular em empresas de marketing on-line e comércio eletrônico, bem como em empresas financeiras para avaliar dados financeiros ou para modelos de investimento, bem como simulações, inteligência artificial e previsão de tendências.

O Spark é usado principalmente pelos seguintes motivos:

- O processamento, a integração e a coleta de conjuntos de dados de diferentes fontes e aplicativos

- A consulta interativa e a análise de big data

- A avaliação de fluxos de dados em tempo real

- Aprendizado de máquina e inteligência artificial

- Processos de ETL de grande porte

Beneficie-se de servidores dedicados com processadores Intel ou AMD e dê uma folga à sua equipe de TI com managed servers da IONOS.

Componentes e bibliotecas importantes na arquitetura do Spark

Entre os elementos mais importantes da arquitetura do Spark estão:

Spark Core

O Spark Core é a base de todo o sistema Spark e disponibiliza os principais recursos do Spark, além de gerenciar a distribuição de tarefas, a abstração de dados, o planejamento de uso e os processos de entrada e saída. O Spark Core usa RDDs distribuídos em vários clusters de servidores e computadores como sua estrutura de dados. Ele também é a base para o Spark SQL, as bibliotecas, o Spark Streaming e todos os outros componentes individuais importantes.

Spark SQL

O Spark SQL é uma biblioteca particularmente bem utilizada, que pode ser usada com RRDs como consultas SQL. Para isso, o Spark SQL gera tabelas DataFrame temporárias. Você pode usar o Spark SQL para acessar várias fontes de dados, trabalhar com dados estruturados, bem como usar consultas de dados via SQL e outras APIs de DataFrame. Além disso, o Spark SQL permite que você se conecte à linguagem de banco de dados HiveQL para acessar um data warehouse gerenciado usando o Hive.

Fluxo de Spark

Essa função de API de alto nível permite que você use funções de streaming de dados altamente dimensionáveis e à prova de erros e processe ou crie continuamente fluxos de dados em tempo real. O Spark gera pacotes individuais para ações de dados a partir desses fluxos. Você também pode empregar módulos de aprendizado de máquina treinados nos fluxos de dados.

Biblioteca de aprendizado de máquina MLIB

Essa biblioteca Spark escalável tem código de aprendizado de máquina para usar processos estatísticos expandidos em clusters de servidores ou para desenvolver aplicativos de análise. Eles incluem algoritmos de aprendizado comuns, como clustering, regressão, classificação e recomendação, serviços de fluxo de trabalho, avaliações de modelos, estatísticas lineares distribuídas e álgebra ou transformações de recursos. Você pode usar o MLlib para dimensionar e simplificar o aprendizado de máquina de forma eficaz.

GraphX

O GraphX da API do Spark funciona para calcular gráficos e combina ETL, processamento interativo de gráficos e análise exploratória.

Como surgiu o Apache Spark?

O Apache Spark foi desenvolvido em 2009 na Universidade da Califórnia, em Berkeley, como parte da estrutura do AMPlabs. Desde 2010, ele está disponível gratuitamente sob uma licença de código aberto. O desenvolvimento e a otimização adicionais do Spark começaram em 2013 pela Apache Software Foundation. A popularidade e o potencial da estrutura de Big Data garantiram que o Spark fosse nomeado como um “projeto de nível superior” pela AFS em fevereiro de 2014. Em maio de 2014, foi publicada a versão 1.0 do Spark. Atualmente (em abril de 2023) o Spark está executando a versão 3.3.2.

O objetivo do Spark era acelerar as consultas e tarefas nos sistemas Hadoop. Com a base do Spark Core, ele permite a transferência de tarefas, as funcionalidades de entrada e saída, bem como o processamento na memória que, de certa forma, supera a estrutura comum do Hadoop, o MapReduce, por meio de suas funções distribuídas.

Quais são os prós do Apache Spark?

Para consultar e processar rapidamente grandes quantidades de dados, o Spark oferece os seguintes benefícios:

- Speed: As cargas de trabalho podem ser processadas e executadas até 100 vezes mais rápido em comparação com o MapReduce do Hadoop. Outros benefícios de desempenho vêm do suporte ao processamento de dados em lote e em fluxo, gráficos cíclicos direcionados, um mecanismo de execução física e otimização de consultas.

- Scalability: Com o processamento na memória de dados distribuídos em clusters, o Spark oferece escalabilidade de recursos flexível e baseada nas necessidades.

- Uniformidade: o Spark funciona como uma estrutura completa de big data que combina diferentes recursos e bibliotecas em um único aplicativo. Entre eles estão as consultas SQL, DataFrames, Spark Streaming, MLlib para aprendizado de máquina e Graph X para processamento de gráficos. Isso também inclui uma conexão com o HiveQL.

- Simpatia do usuário: graças às interfaces de API fáceis de usar para diferentes fontes de dados, bem como mais de 80 operadores comuns para desenvolver aplicativos, o Spark conecta várias opções de aplicativos em uma única estrutura. É particularmente útil quando se usam shells Scala, Python, R ou SQL para escrever serviços.

- Quadro de código aberto: Com seu design de código aberto, o Spark oferece uma comunidade ativa e global composta por especialistas que desenvolvem continuamente o Spark, eliminam lacunas de segurança e promovem melhorias rapidamente.

- Aumento da eficiência e redução de custos: como você não precisa de estruturas físicas de servidores de alto nível para usar o Spark, quando se trata de análise de big data, a plataforma é um recurso poderoso e redutor de custos. Isso é especialmente verdadeiro para algoritmos de aprendizado de máquina com uso intensivo de computador e processos de dados paralelos complexos.

Quais são os contras do Apache Spark?

Apesar de todos os seus pontos fortes, o Spark também tem algumas desvantagens. Uma delas é o fato de que o Spark não tem um mecanismo de armazenamento integrado e, portanto, depende de muitos componentes distribuídos. Além disso, devido ao processamento na memória, você precisa de muita RAM, o que pode causar uma falta de recursos que afeta o desempenho. Além disso, se você usar o Spark, levará muito tempo para se acostumar com ele, para entender os processos em segundo plano ao instalar seu próprio servidor Web Apache ou outra estrutura de nuvem usando o Spark.