Seo para Google: factores de ranking en 2016 según Searchmetrics

La compañía alemana Searchmetrics, propietaria de la conocida herramienta de SEO Searchmetrics Suite, también se dedica desde 2012 a elaborar un estudio anual con profundos análisis en torno a la clasificación en los buscadores. Este año, sin embargo, este análisis de los factores de ranking en Google se publica en su forma actual por última vez, al considerar la empresa que la era de las checklists generales sobre SEO ha tocado a su fin. En el futuro, el hasta ahora informe anual sobre SEO de la compañía ha de abrazar análisis específicos diferenciados por sector. La razón principal reside, entre otras cosas, en el nuevo sistema de inteligencia artificial de Google RankBrain, un algoritmo que utiliza el aprendizaje automático de las máquinas para actuar de una forma mucho más flexible que los algoritmos de búsqueda antiguos. Fue en junio de 2016 cuando Jeff Dean, ingeniero informático en Google, reveló al periodista informático Steven Levy que, en el futuro, RankBrain estaría implicado en el procesamiento de todas las peticiones al buscador. Según el reportaje de Levys en Backchannel, este sistema de inteligencia artificial se cuenta hoy en día entre los tres factores de clasificación en los buscadores más importantes. Con el estudio actual “Ranking Factors - Rebooting for Relevance”, Searchmetrics sigue presentando un catálogo de factores en correlación con la clasificación en el buscador, pero las conclusiones del examen se entienden más bien como valores orientativos para análisis individuales más específicos adaptados a cada sector en particular. Como en los años anteriores, el estudio está basado en un conjunto de 10.000 palabras clave relevantes. Los hallazgos actuales se interpretan a la luz de las investigaciones precedentes. A continuación, puedes leer las conclusiones más relevantes del estudio de Searchmetrics sobre los factores de ranking en 2016.

Factores de contenido

Especialmente desde la más reciente actualización del principal algoritmo de Google, Searchmetrics está aún más convencido de que, a la hora de optimizar una página para el buscador, el contenido es un aspecto prioritario. En este sentido, un factor central es aquí la relevancia del contenido (content relevance), evaluado ahora por primera vez como un factor de ranking en sí mismo. En cambio, la optimización sobre la base de palabras clave pierde importancia frente a una composición holística del texto.

La relevancia del contenido pasa a ser un factor de ranking clave

El buen contenido se caracteriza porque se corresponde con la intención del usuario, que no es la misma en cada búsqueda. El desafío para los responsables de contenido es, por ello, satisfacer tantas búsquedas como sea posible con un solo texto. Una estrategia posible a la hora de crear contenido podría apoyarse precisamente en la creación de textos holísticos que observen diferentes aspectos de un tema y que estén optimizados a partir de palabras clave de un campo temático relacionado semánticamente. El objetivo del contenido holístico es, así, lograr buenas posiciones en las listas de resultados para varias palabras clave relevantes. La palabra clave aislada pierde entonces en relevancia.

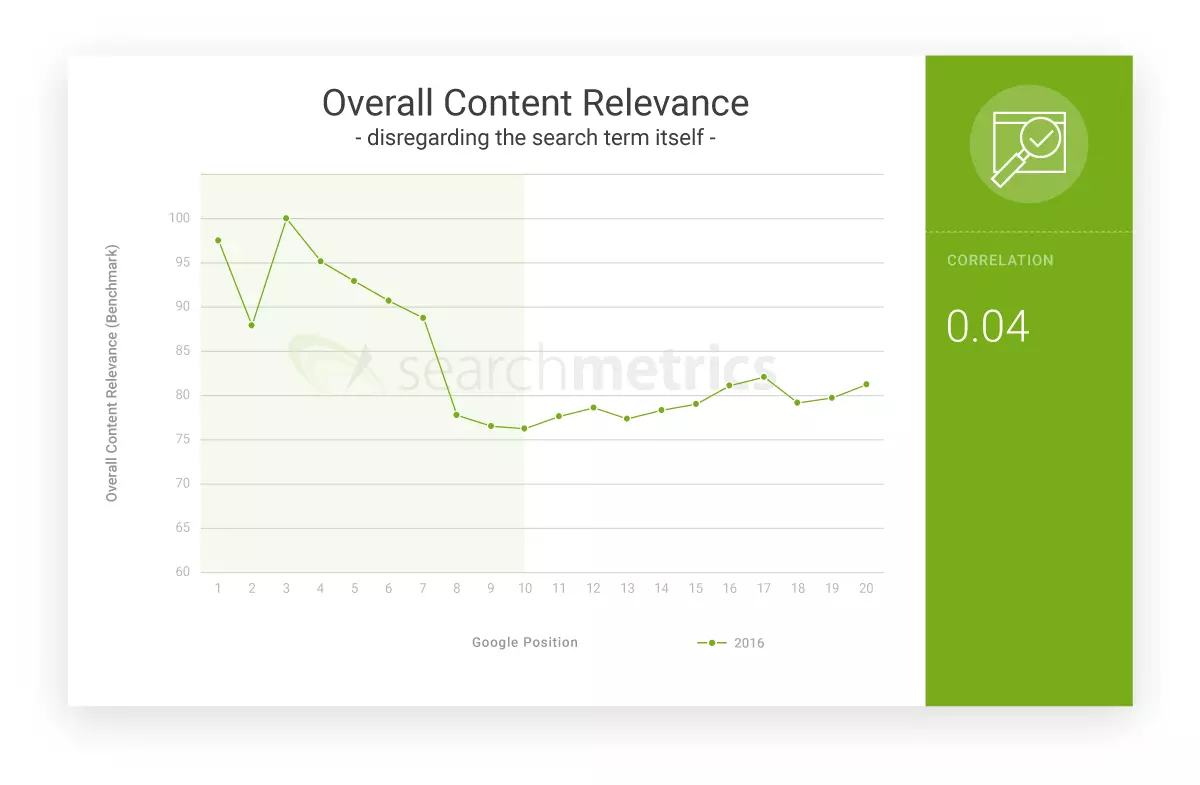

En el estudio de Searchmetrics se analiza la relevancia del contenido de un texto en relación con el término de búsqueda empleado, lo que tiene lugar sobre la base del corpus lingüístico y la conceptualización de las relaciones semánticas. El resultado es poco sorprendente:

[“Los URL con la mayor relevancia de contenido son los que se encuentran entre la tercera y la sexta posición”]

En las posiciones subsiguientes la nota en relevancia va bajando de forma constante. En cuanto a la primera y la segunda posición, estas suelen corresponder, según Searchmetrics, a páginas de marcas muy conocidas, que aprovechan ranking factors corporativos, como reconocimiento, confianza e imagen, para posicionarse bien, pero que no necesariamente han de agradecer su clasificación a la relevancia del contenido.

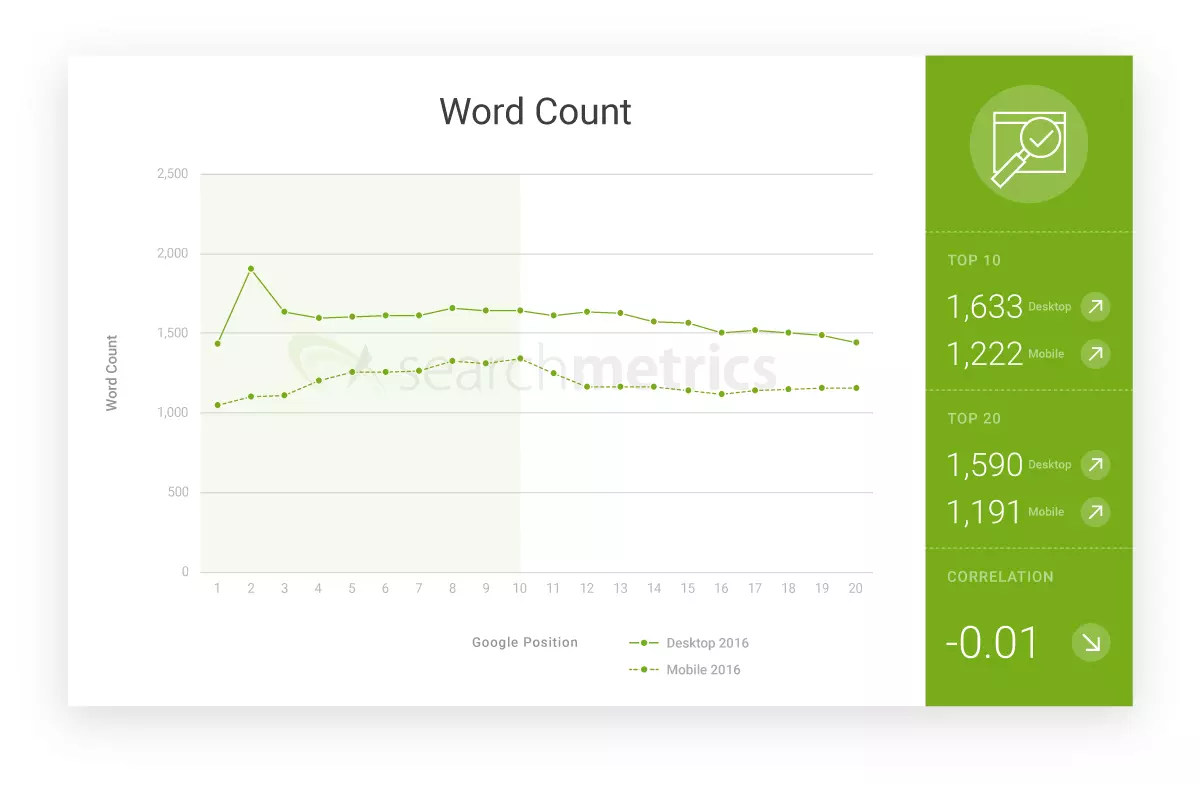

Aumenta el número medio de palabras

La cantidad media de palabras de las páginas mejor posicionadas aumenta de forma constante desde hace años. Según Searchmetrics, esto sería un reflejo del trabajo intensivo en torno al tema que las ocupa, en el sentido de una creación de contenido de forma holística (total).

[“La cantidad media de palabras aumenta en un 50 % en 2016”]

Si se compara el número de palabras en los contenidos para la versión de escritorio con el de las landing pages móviles las diferencias son muy claras: en general, las versiones de escritorio de una página son de media un 30 por ciento más largas que sus homólogas móviles.

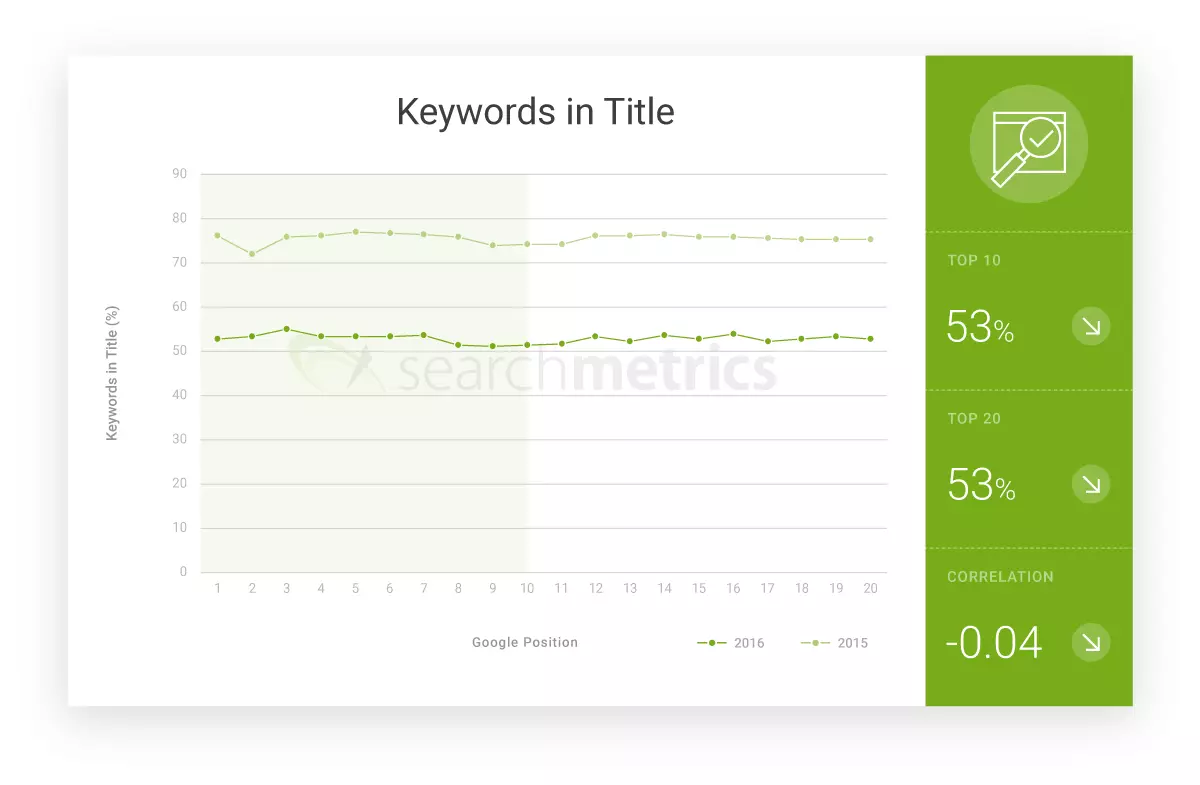

La palabra clave en el meta título pierde relevancia

En los departamentos de SEO, el credo sigue siendo que la palabra clave ha de estar incluida en el metatitle y, si puede ser, tan adelante como sea posible. Searchmetrics, en cambio, demuestra en sus análisis lo poco que esta creencia se acerca a la realidad:

[“En 2016, solo un 53 % de las primeras 20 páginas tenían la palabra clave en el título”]

Esta evolución también se explica a partir del principio holísitico de la creación de contenido, por el cual los textos no se optimizan en función de las palabras clave sino de los temas. El algoritmo inteligente de Google es capaz ya de evaluar relaciones semánticas sin tener en cuenta necesariamente a las palabras clave.

Esta evolución es parecida en el caso del título y la meta descripción. Según concluye Searchmetrics, solo un tercio de todas las landing pages en las primeras 20 posiciones incluye la palabra clave principal en el título principal (H1).

Señales de usuario

Para determinar si el usuario de Google está satisfecho con las páginas propuestas por el buscador, la compañía no se limita a confiar en factores indirectos tales como el análisis semántico del contenido de las páginas. Otros productos de la factoría californiana como el navegador Chrome, el plugin de analítica web Analytics, el sistema publicitario AdWords y el sistema operativo Android le entregan también información exhaustiva sobre los hábitos de navegación del usuario de Google.

Gracias a señales tan inequívocas como las tasas de clics o de rebote, así como la permanencia media en las webs, combinadas con una base de datos gigantesca, Google puede evaluar detalladamente si una página web ofrece lo que promete y aplicar este conocimiento en tiempo real al ranking utilizando métodos del aprendizaje automático. También en este aspecto, el estudio de Searchmetrics ofrece un valioso input para propietarios de páginas web y asesores de SEO.

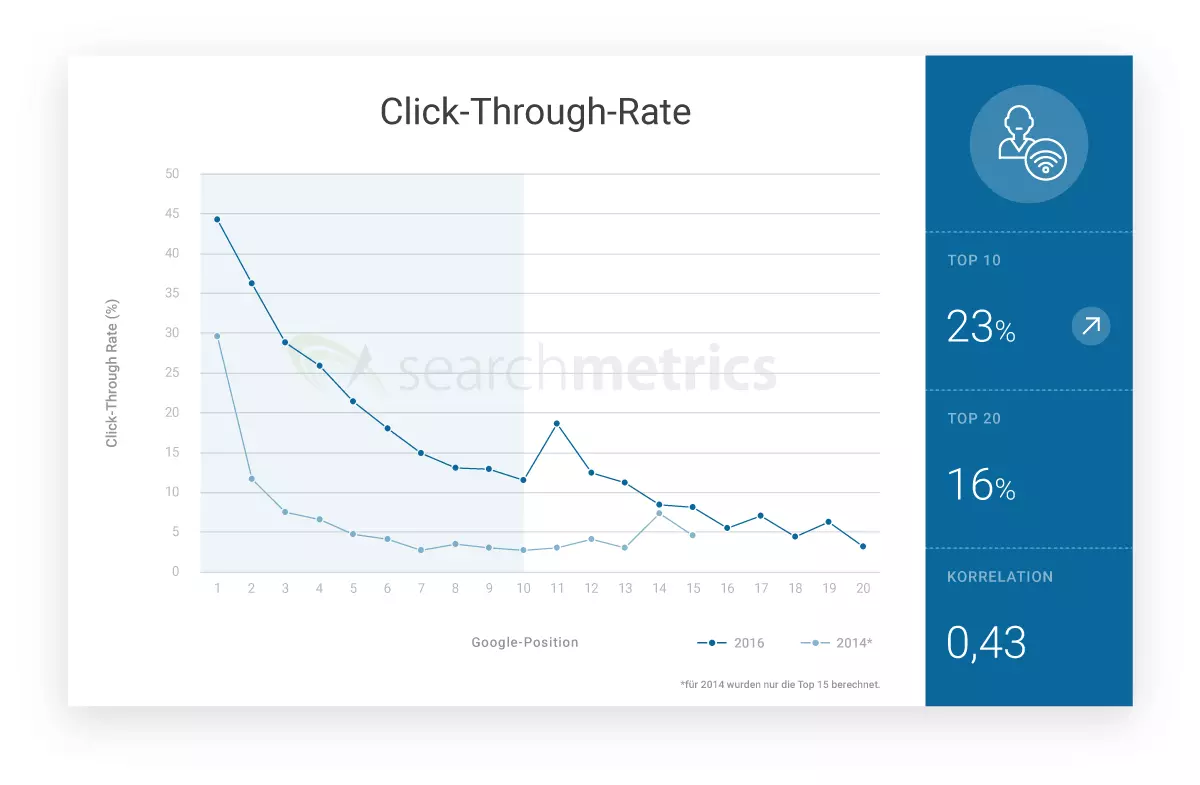

La tasa media de clics en las 3 primeras posiciones es de un 36 %

La confianza de los usuarios en la valoración de la relevancia que efectúa el buscador es elevada. Ya lo demostró el estudio de Searchmetrics de 2014, en el cual se extrajo la tasa media de clics (Click-Throug Rate o CTR) de los top URL analizados.

En consecuencia, las páginas en la posición 1 acaparan la mayor parte de clics. Para la pole position, el equipo de Searchmetrics ha calculado una CTR media de un 44 %, un porcentaje que desciende a medida que la página baja en posiciones. En la tercera posición la tasa de clics ya es de un 30 %.

[“Las páginas entre la primera y la tercera posición tienen una CTR media de un 36 %”]

Resulta llamativo el claro aumento de la CTR en la posición 11, que equivale a la primera landing page de la segunda página de resultados del buscador, la cual recibe de media más clics que las posicionadas al final de la primera página.

Comparada con 2014, la tasa media de clics en las 10 primeras posiciones ha aumentado visiblemente.

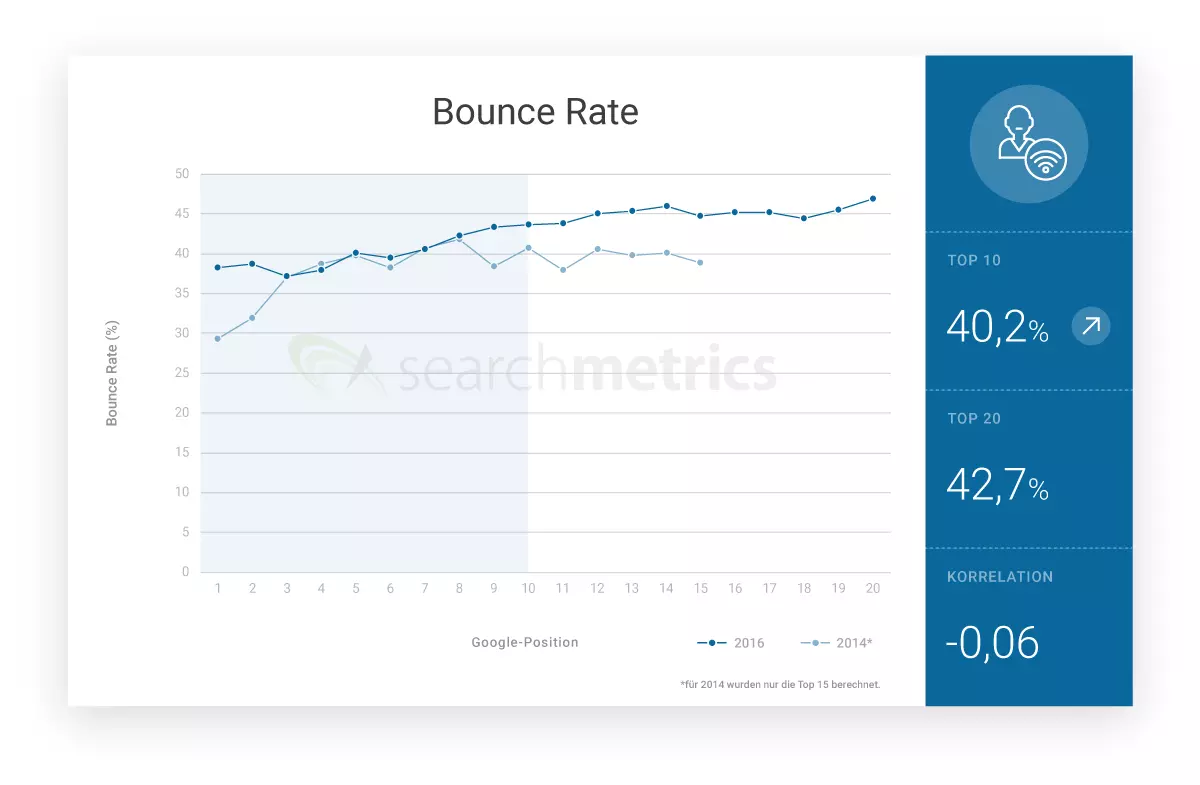

La tasa de rebote en la primera página de resultados aumenta en un 46 %

Junto a la tasa de clics, la tasa de rebote (Bounce rate) también resulta interesante a la hora de evaluar la relevancia de una página web. Esta indica cuántos usuarios vuelven a Google.com después de hacer clic en un resultado, sin visitar otras subpáginas de la web seleccionada. En los URL examinados, el equipo de Searchmetrics detectó un aumento del 46 % en la tasa de rebote en las 10 primeras posiciones respecto de 2014. Esta diferencia resulta especialmente clara en las dos primeras posiciones.

Según los analistas, sin embargo, la tasa de rebote solo puede explicar la relevancia de una web parcialmente, porque el abandono de una página se debe siempre a motivos individuales y, en casos aislados, también si el motivo de la búsqueda se responde satisfactoriamente. Este sería el caso, por ejemplo, de aquellas búsquedas puramente informacionales que un glosario o un diccionario puede responder casi a primera vista.

La explicación al aumento de la tasa de rebote registrado en el estudio tiene que ver, para el equipo de analistas de Searchmetrics, con la elevada calidad del algoritmo de Google. Gracias al nuevo sistema de inteligencia artificial el buscador tiene hoy la capacidad de seleccionar exactamente la página que mejor se corresponde con la intención de búsqueda del usuario, de forma que este ya no tiene la necesidad de seguir buscando en el dominio hasta encontrar la información que se buscaba.

Aumenta el tiempo medio de permanencia

El tiempo que pasa entre el primer clic sobre el URL que ofrece el buscador y el abandono, el denominado time on site, es de especial importancia a la hora de evaluar la relevancia de una página web y puede medirse exactamente mediante procedimientos de analítica web. Searchmetrics también presenta aquí un valor medio digno de una consideración diferenciada.

[“El time on site para las 10 primeras páginas es de 3 minutos y 10 segundos”]

Si se comparan los datos de este estudio con los obtenidos en 2014, se reconoce un aumento visible del tiempo de permanencia en las primeras 10 posiciones, un desarrollo lógico si se piensa que aquellos propietarios de páginas que quieren posicionar bien en Google se esfuerzan por ofrecer contenido de gran calidad.

No obstante, aun cuando un tiempo alto de permanencia permite inferir un contenido de calidad, tampoco significa automáticamente que una permanencia más breve se deba a una landing page de menor calidad. Una página web puede satisfacer bastante rápido la sed de información de un usuario que busca meramente qué tiempo hará mañana o el resultado del último partido de su equipo de fútbol.

Factores técnicos y de usabilidad

La elaboración de contenido cualitativo solo es uno de los pilares del SEO para Google y otros buscadores. Sin unas condiciones técnicas de base, incluso el mejor contenido lo tendrá difícil para alcanzar las mejores posiciones en el ranking. Hoy, las webs contemporáneas han de tener en cuenta factores tan relevantes como rendimiento, seguridad y usabilidad.

Entre los aspectos técnicos involucrados en la publicación de contenido, además de factores generales como el tiempo de carga y el tamaño de los archivos, dos tendencias destacan en 2016 especialmente. Por un lado, cada vez más propietarios de páginas web se preocupan por ofrecer a sus visitas contenido en versión móvil, y, por el otro, Searchmetrics subraya el significado del cifrado con HTTPS para posicionar en el buscador.

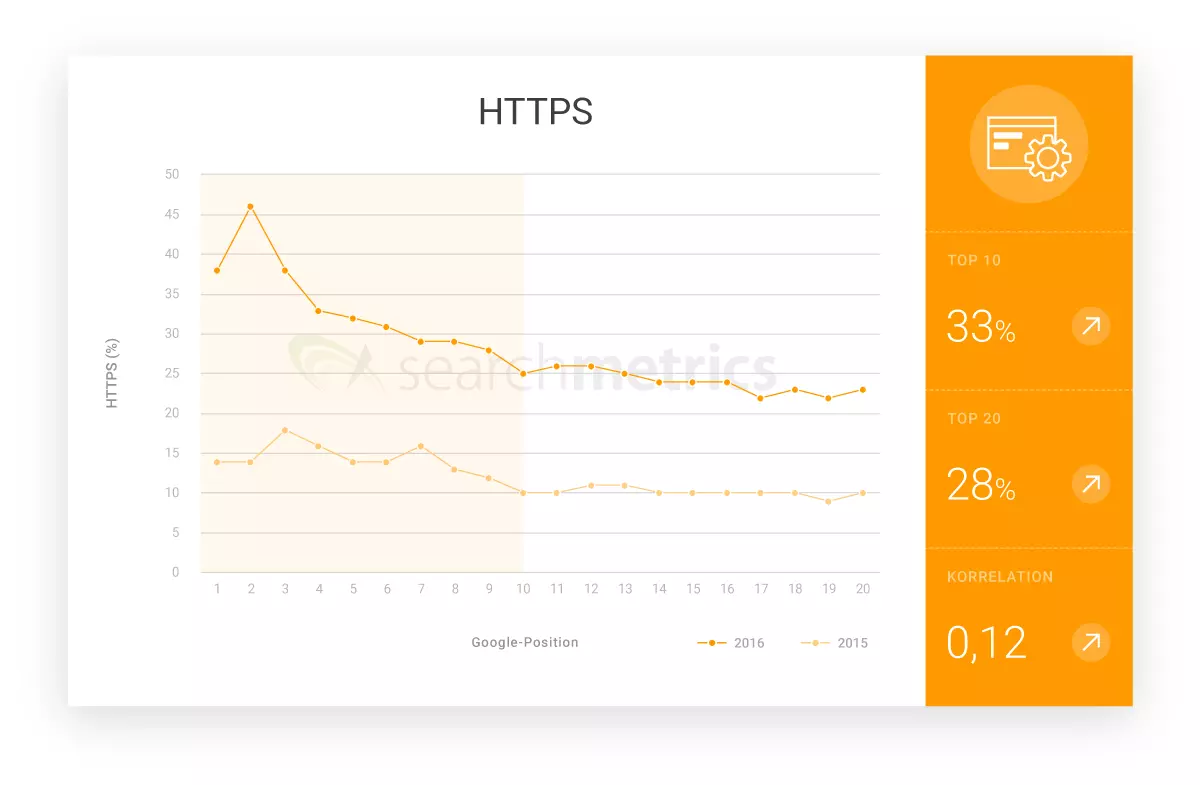

2017 será el año de HTTPS

Los responsables de páginas web que en 2017 sigan ignorando la transmisión cifrada de datos con HTTPS lo van a tener muy difícil para ascender posiciones en la clasificación del buscador. Ya en septiembre de 2016 Google anunció que aquellas páginas HTTP que procesan datos sensibles serán marcadas a partir de 2017 como inseguras. No hace falta ser ningún experto en SEO para darse cuenta de lo que este sello digital puede ocasionar en términos de visitas y clics.

No solo por este motivo aumenta constantemente el número de páginas cifradas con HTTPS. Si el año anterior el porcentaje de páginas entre las 10 primeras posiciones que apostaban por el cifrado era de un 12 %, en el estudio actual Searchmetrics pudo registrar un significativo aumento del 45 %.

[“Casi la mitad de las páginas en el top ten usan el cifrado HTTPS.”]

Optimización para móviles: requisito para un buen ranking

Las búsquedas realizadas desde dispositivos móviles aumentan constantemente. Según un informe de Google de 2015, el buscador registra más peticiones desde dispositivos móviles que desde equipos de escritorio en mercados tan relevantes como Estados Unidos o Japón. La estrategia Mobile First de Google muestra la relevancia que en el futuro tendrá el enfoque mobile friendly para la clasificación en el buscador. En octubre de 2016, la compañía anunció que en el futuro usaría el índice móvil como índice principal para la búsqueda web, de lo que se deduce que este también tendrá un efecto en la clasificación en las búsquedas desde dispositivos de escritorio. Aquellos administradores que aún no se hayan ocupado de la optimización móvil, deberían planificar para 2017 las modificaciones necesarias en el diseño de sus webs como tarea prioritaria. Para ello pueden recurrir a los subdominios móviles, al diseño web responsivo o al contenido dinámico.

Señales sociales

Como ya en 2014, el estudio de Searchmetrics sobre los factores de ranking en 2016 muestra de nuevo una elevada correlación entre una buena clasificación en el buscador y los denominados social signals o señales sociales. Estas consisten en señales comunicativas como Shares, Likes y comentarios en redes sociales como Facebook, Twitter, Pinterest o Google+. Sin embargo, hallar la relación causal entre una buena posición en el buscador y la presencia en redes sigue siendo difícil para los analistas.

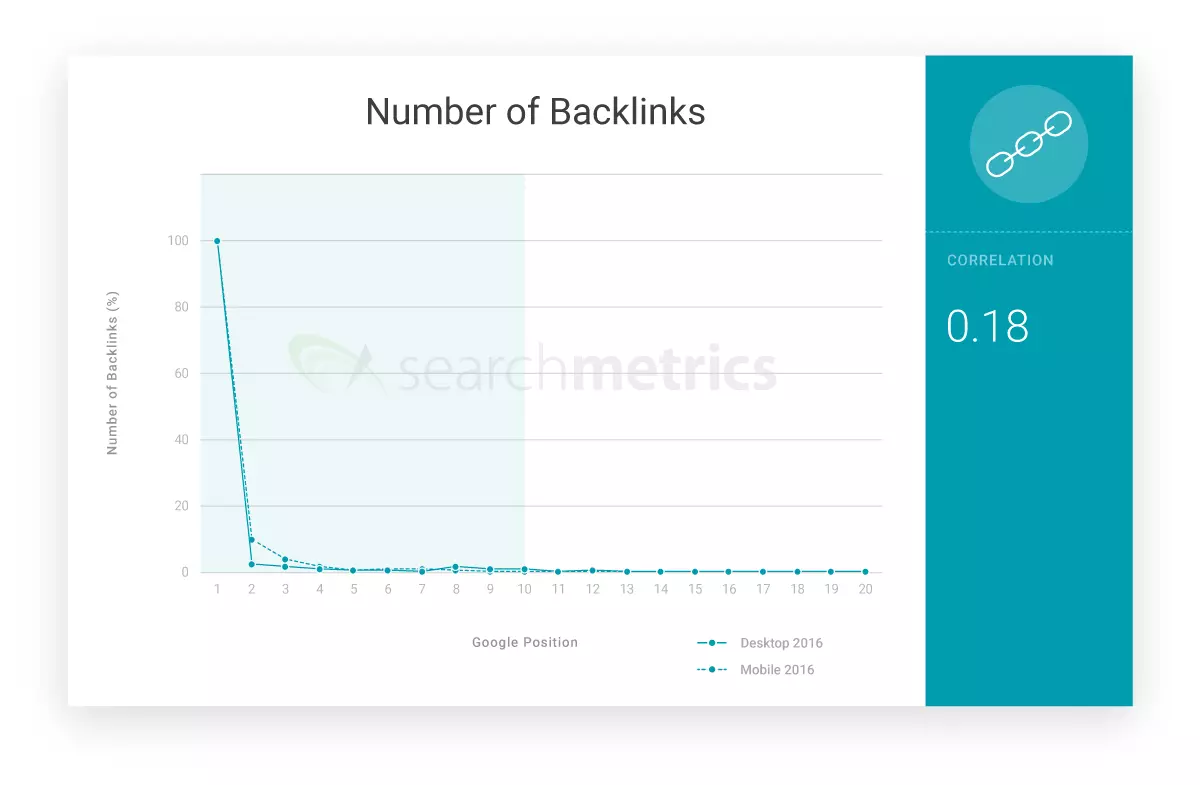

Backlinks

El número de enlaces entrantes de una página web también se corresponde con la posición de la misma en el buscador, pero, en términos de SEO, la estructura de enlaces está pasando a un segundo plano. Según Searchmetrics, el perfil de enlaces de una web ha dejado de ser el factor decisivo de éxito en Google para pasar a ser uno de tantos.

El buscador es hoy capaz de evaluar la calidad de una página en función de las relaciones semánticas y de las señales directas de los usuarios, de modo que el perfil de enlaces pierde su influencia en la relevancia del contenido como factor cualitativo. Si durante mucho tiempo los enlaces desde páginas representativas estaban muy bien valorados, en el futuro los webmasters tendrán que preguntarse en qué medida el contenido que ofrecen en sus landing pages cumple con las expectativas de los usuarios.

Por ahora, no obstante, según el recién publicado estudio de Searchmetrics, no hay que temer por la desaparición completa de los backlinks del algoritmo de Google en un futuro cercano, aunque la optimización basada exclusivamente en el perfil de enlaces sí tiene los días contados.

[“Las correlaciones para los backlinks siguen siendo altas, pero su importancia para el ranking seguirá decreciendo”]

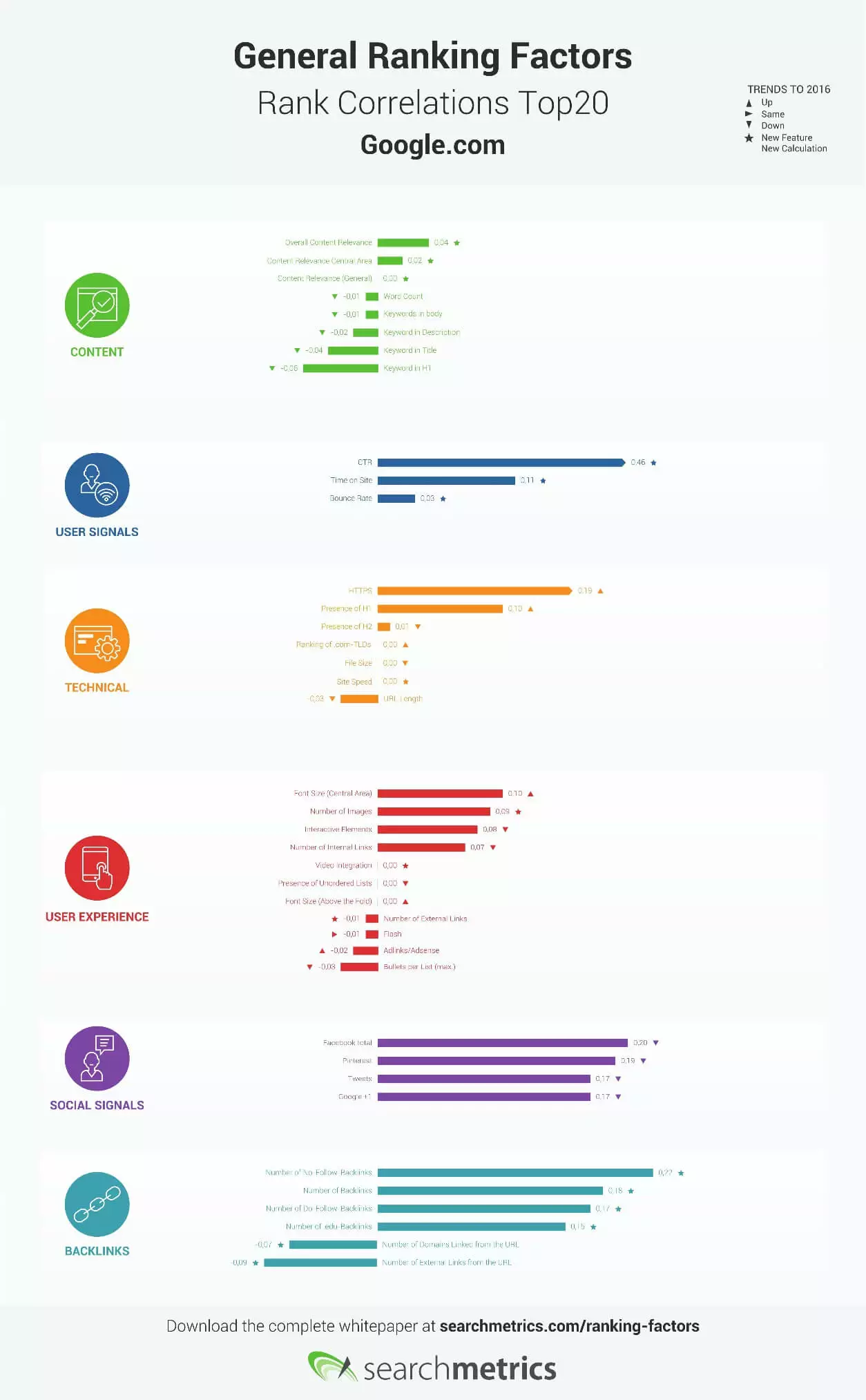

Los factores de ranking en 2016 en correlación con la posición en el buscador

El siguiente gráfico muestra la correlación entre la clasificación en el buscador y los factores de ranking para las veinte páginas mejor posicionadas estudiadas por Searchmetrics, así como su evolución en función del año anterior. Los factores de ranking para los cuales se obtuvieron datos por primera vez en 2016, así como aquellos que se han calculado de nuevo, se han marcado con un asterisco.

Conclusión: el futuro del SEO

El estudio “Ranking Factors - Rebooting for Relevance” de Searchmetrics muestra que sigue habiendo factores que se relacionan con una buena clasificación en Google. Estos, sin embargo, no pueden aplicarse de la misma manera a todas las páginas web. Un listado general de factores de ranking deviene insuficiente para retratar las diversas exigencias que tanto el hombre como la máquina plantean a las páginas web en función del sector.

Es por eso que el equipo de Searchmetrics anuncia, con la publicación de su trabajo actual, la nueva orientación que este tomará en el futuro, más centrado en estudios diferenciados que contemplen las peculiaridades de los diferentes sectores. El estudio anual a propósito de los factores de ranking en 2016 y su correlación con la posición se basará, además, en sets de palabras clave propios del sector (eCommerce, salud, finanzas, etc.) en que se mueva la web. Esto permite contemplar el estudio de Searchmetrics de 2016 como una especie de aviso a navegantes para que los webmasters dejen de fijarse en checklists generales e interpreten tendencias y pronósticos de SEO en relación con su sector.